La Data Science transforme le bruit numérique en décisions claires : en extrayant des motifs, en testant des hypothèses et en construisant des modèles prédictifs, elle permet aux organisations de passer de l’intuition aux actions mesurables. Ce qu’il faut retenir d’emblée, c’est que la Data Science n’est pas seulement une boîte à outils techniques — c’est un processus complet qui va de la collecte à la communication, en passant par la qualité des données, la modélisation et la mise en production. Prenons Aurélie, data scientist chez Novacorp : chaque matin elle nettoie des jeux de données hétérogènes, teste plusieurs algorithmes et présente des visualisations claires aux opérationnels. Grâce à cette chaîne, Novacorp améliore sa chaîne logistique et réduit ses coûts. Dans un monde où les données proviennent des téléphones, des capteurs et des plateformes en ligne, comprendre comment transformer ces flux en insights exploitables est devenu stratégique pour la plupart des secteurs. Ce texte vous guide pas à pas : définitions, composants techniques, cas concrets, contraintes de stockage et défis éthiques — avec des exemples concrets et des pistes pour agir.

- En bref : la Data Science convertit des données brutes en décisions opérationnelles.

- Processus clé : collecte → nettoyage → modélisation → visualisation → déploiement.

- Technologies centrales : Big Data, machine learning, cloud et outils comme Dataiku.

- Applications pratiques : santé, industrie, transport, finance, marketing.

- Défis majeurs : qualité des données, confidentialité, intégration d’outils et gouvernance.

Qu’est-ce que la Data Science : définition et posture métier

La notion essentielle : la Data Science est une discipline interdisciplinaire qui combine statistique, informatique et compréhension métier pour extraire des connaissances utiles à partir de données massives.

Concrètement, on ne parle pas seulement d’algorithmes : il s’agit d’un enchaînement — trouver les bonnes sources, s’assurer de la qualité, choisir des modèles pertinents, et présenter les résultats à des décideurs. Aurélie passe souvent plus de temps à préparer les données qu’à entraîner des modèles, et c’est normal : la fiabilité commence là.

- Ce qu’elle englobe : collecte, nettoyage, exploration, modélisation, validation et mise en production.

- Compétences requises : statistiques, programmation (Python/R), ingénierie des données, communication.

- Résultat attendu : insights actionnables, tableaux de bord, API prédictives.

Cas concret — de la donnée brute à l’action

Chez Novacorp, un projet permet de prédire les ruptures de stock. L’équipe commence par agréger données de ventes, capteurs IoT et retours clients. Ensuite, elle nettoie et enrichit les jeux de données avant de tester plusieurs modèles.

- Étape 1 : ingestion des données hétérogènes.

- Étape 2 : nettoyage et feature engineering.

- Étape 3 : entraînement et validation du modèle.

- Étape 4 : déploiement en production et monitoring.

Insight : la valeur réelle vient de la boucle complète — du nettoyage jusqu’au suivi après déploiement.

Composantes clés et technologies de la Data Science

Pour être opérationnelle, la Data Science s’appuie sur plusieurs briques complémentaires : Big Data, machine learning, systèmes distribués, cloud et outils de visualisation. Sans ces briques, les modèles restent des preuves de concept sans impact réel.

- Stockage et calcul : systèmes distribués, data lakes, cloud providers.

- Modélisation : régression, arbres, réseaux neuronaux, modèles probabilistes.

- Outils : Python, R, Dataiku, Power BI, Tableau.

- Opérations : CI/CD ML, monitoring des modèles, gouvernance des données.

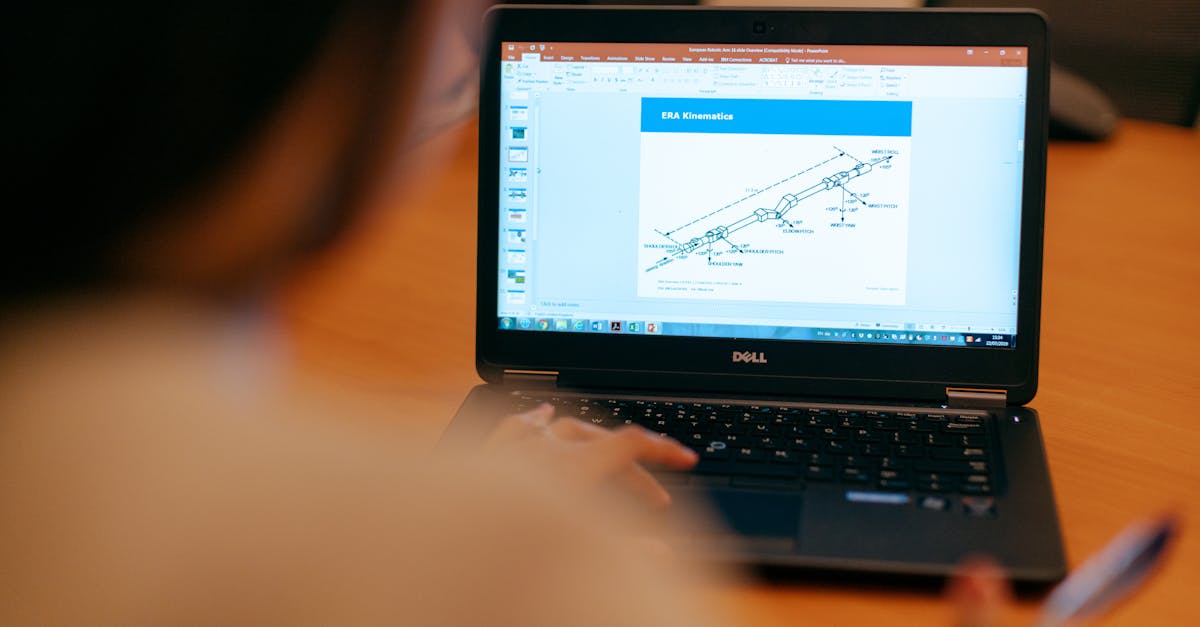

Exemple d’architecture technique

Imaginez l’architecture d’Aurélie : ingestion via pipelines Kafka, stockage dans un data lake S3, traitements Spark pour l’ETL, entraînement sur GPU dans le cloud et déploiement via containers. Chaque couche a ses contraintes et ses choix technologiques.

- Pourquoi Spark ? pour traiter des volumes massifs en parallèle.

- Pourquoi containers ? pour la portabilité et le déploiement rapide.

- Pourquoi monitoring ? pour détecter la dérive des modèles en production.

Insight : c’est l’architecture qui transforme un modèle en service fiable et scalable.

Applications et impact sectoriel de la Data Science

La Data Science est devenue un levier stratégique dans de nombreux secteurs. Elle améliore les diagnostics médicaux, personnalise les traitements, optimise la production industrielle et affine les campagnes marketing. Chaque secteur exploite les mêmes principes mais avec des jeux de contraintes différents.

- Santé : analyses génomiques et prédiction des risques.

- Industrie : maintenance prédictive et optimisation des chaînes.

- Transport : optimisation des itinéraires et sécurité.

- Finance : détection de fraude et gestion des risques.

- Marketing : segmentation fine et recommandations personnalisées.

Étude de cas — logistique intelligente

Novacorp a réduit ses coûts de 12 % en 9 mois grâce à un modèle prédictif qui anticipe les demandes régionales et ajuste les réassorts. Le projet a combiné données externes (météo, événements) et données internes pour affiner les prévisions.

- Métrique suivie : précision des prévisions à 7 jours.

- Impact business : réduction des surstocks et des ruptures.

- Leçon : intégrer des données externes augmente souvent la robustesse des modèles.

Insight : l’impact réel se mesure en valeur économique, pas seulement en score statistique.

Défis du stockage, de la qualité et de la gestion des données

Stocker des pétaoctets n’est plus le seul défi : il faut garantir la qualité, la traçabilité et la conformité. Les données proviennent de sources très variées — capteurs, logs, formulaires — et nécessitent des stratégies différentes pour rester utiles.

- Qualité : données manquantes, incohérences, biais.

- Infrastructure : coûts de stockage, latence, scalabilité.

- Interopérabilité : formats variés, API et schémas.

Solutions pratiques et bonnes pratiques

Parmi les approches efficaces : pipeline d’ingestion robuste, validation des schémas en amont, catalogues de données et tests automatisés. Aurélie a mis en place des checks réguliers qui ont éliminé 30 % des erreurs de production en quelques semaines.

- Automatiser les tests de qualité des données.

- Mettre en place un catalogue pour la gouvernance.

- Choisir le stockage selon les accès (froid vs chaud).

Insight : la gouvernance et la qualité des données sont des prérequis pour toute analyse fiable.

Analyse, interprétation et enjeux éthiques

L’analyse statistique et le machine learning posent des questions d’interprétation et d’éthique : biais algorithmiques, confidentialité, explicabilité. Un modèle performant peut être erroné si les données reflètent des inégalités historiques.

- Explicabilité : rendre les décisions compréhensibles pour les utilisateurs.

- Confidentialité : anonymisation, politiques de rétention, conformité légale.

- Biais : détection et correction en amont.

Pratiques recommandées

Implémenter des revues d’impact, utiliser des méthodes d’explicabilité (SHAP, LIME), et documenter les datasets via des datasheets. Ces démarches réduisent les risques réglementaires et favorisent la confiance des utilisateurs.

- Audit des modèles avant déploiement.

- Documentation des choix et des limites.

- Formation des équipes métiers à l’interprétation des résultats.

Insight : l’éthique n’est pas un frein mais un accélérateur de valeur durable.

Acteurs, écosystème et ressources pratiques

Le marché de la Data Science regroupe des éditeurs, des cabinets de conseil et des entreprises spécialisées. Plusieurs acteurs se distinguent par leur expertise et leurs offres, et ils accompagnent les organisations depuis la stratégie jusqu’à la mise en production.

- Outils et plateformes : Dataiku pour l’orchestration et la collaboration.

- Grandes ESN : Capgemini, Atos qui proposent des intégrations à grande échelle.

- Cabinets spécialisés : Quantmetry, Talan, Octo Technology, Business & Decision.

- Acteurs SEO & données : Netquest, Eskimoz pour des besoins spécifiques d’audience et référencement.

Pour s’informer au quotidien, on peut lire des retours d’expérience sur des plateformes dédiées, ou consulter des guides pratiques. Par exemple, pour des sujets technos de la vie quotidienne et des analyses, on peut parcourir des articles comme innovations technologiques du quotidien ou des dossiers pratiques sur des services en ligne.

Ressources complémentaires et lectures utiles :

- Comparaisons de services en ligne : meilleure plateforme de streaming (exemple d’analyse comparative).

- Guides pratiques pour accéder à des services : guide DPStream.

- Informations liées aux outils de voyage et données publiques : informations Google Flights.

- Articles de fond sur tendances et usages : innovations technologiques du quotidien (autre angle).

- Analyse d’audience et profils : personnalités emblématiques et cartes (exemple de visualisation de données).

Insight : connaître l’écosystème aide à choisir le bon partenaire pour chaque étape du projet.

Qu’est-ce qui distingue la Data Science de l’analyse de données classique ?

La Data Science combine ingénierie des données, statistique avancée et machine learning pour produire des modèles prédictifs et automatisés. L’analyse de données classique se concentre souvent sur le reporting et l’exploration descriptive, tandis que la Data Science vise aussi la prédiction et l’automatisation des décisions.

Quels sont les premiers outils à apprendre pour débuter ?

Commencez par Python et ses bibliothèques (pandas, scikit-learn), puis familiarisez-vous avec un outil de visualisation (Tableau, Power BI) et une plateforme d’orchestration comme Dataiku. Les bases en SQL et en gestion de données sont indispensables.

Comment évaluer la qualité d’un dataset avant de modéliser ?

Contrôlez l’intégrité des données, le taux de valeurs manquantes, la cohérence des types, la présence de biais et la distribution des variables. Automatisez ces checks et documentez les anomalies pour garder une traçabilité.

Quelles sont les principales contraintes réglementaires à considérer ?

Respectez les règles de confidentialité (ex. protection des données personnelles), appliquez des politiques de rétention, anonymisez si nécessaire et documentez les finalités de traitement pour rester conforme aux normes en vigueur.