Idée essentielle : la matrice de confusion est l’outil central pour comprendre non seulement combien un modèle de classification supervisée se trompe, mais surtout quel type d’erreur il commet — et donc comment l’améliorer.

Quand Sophie, data scientist chez ClinicoData, présente un modèle de dépistage en 2025, elle commence toujours par la même phrase : « regardons la matrice de confusion ». Ce tableau simple révèle si l’algorithme confond des cas sains avec des malades, s’il génère trop de fausses alertes, ou s’il manque des cas critiques. Dans un monde où une erreur de classification peut coûter cher — en santé, sécurité ou expérience utilisateur —, la matrice permet d’orienter des décisions concrètes : ajuster le seuil de décision, rééquilibrer les données, ou prioriser la réduction des Faux Négatifs (FN) plutôt que des Faux Positifs (FP). Ici, on va décortiquer la Définition matrice de confusion, détailler les métriques dérivées (précision, rappel, score F1, exactitude), montrer des Exemples matrice de confusion sur des cas réels — diagnostic médical, spam, classification d’images — et donner des pistes pratiques pour améliorer la performance modèle. Chaque section apporte des listes d’actions, des illustrations et une petite histoire métier pour rendre l’Analyse des prédictions utile et opérationnelle.

- Comprendre la matrice de confusion : ce qu’elle montre et pourquoi c’est critique.

- Définition matrice de confusion : composants clés — TP FP TN FN.

- Exemples matrice de confusion : cas médicaux, spam, images, avec conséquences pratiques.

- Analyse des prédictions : métriques (précision, rappel, F1, exactitude) et choix d’arbitrage.

- Évaluation de modèle : visualisation, outils et actions concrètes pour réduire les erreurs.

Comprendre la matrice de confusion : définition matrice de confusion et composants

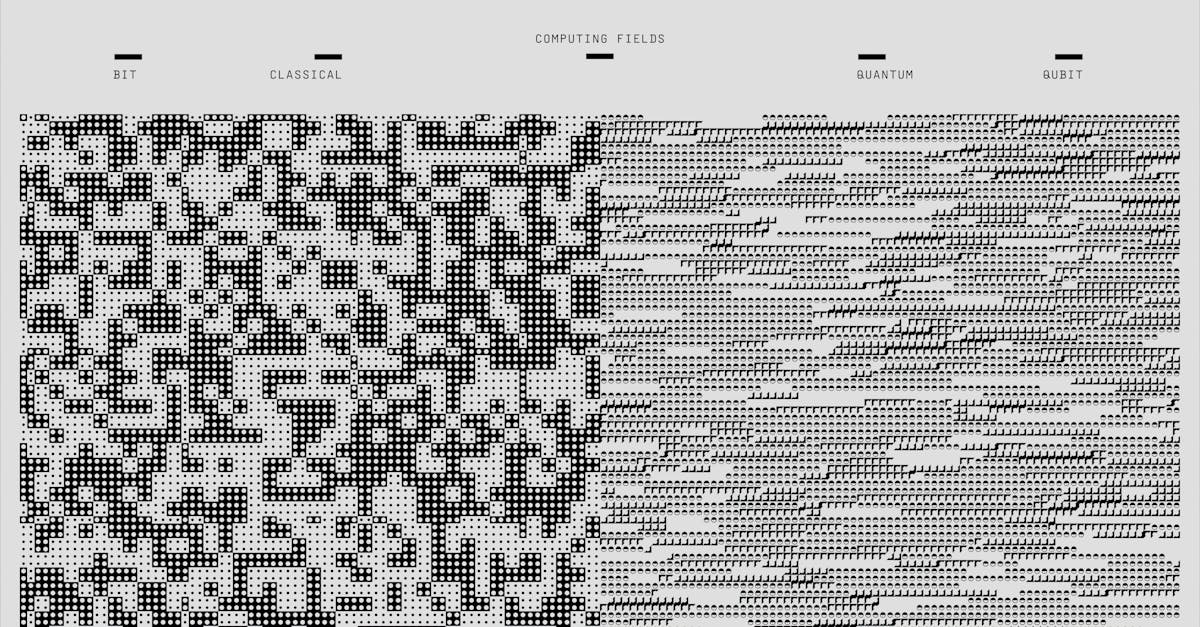

La matrice de confusion est un tableau qui confronte les décisions du modèle aux valeurs réelles. C’est le point de départ pour diagnostiquer une erreur de classification : on voit si les erreurs touchent plutôt la détection (sensibilité) ou l’exclusion (spécificité).

Sophie illustre toujours avec quatre cases évidentes : les Vrais Positifs (TP), les Faux Positifs (FP), les Faux Négatifs (FN) et les Vrais Négatifs (TN). Ces quatre nombres racontent une histoire sur le comportement du modèle en production.

- TP : cas positifs correctement identifiés — utile pour mesurer la capacité à détecter.

- FP : cas négatifs pris pour positifs — source de fausses alertes et coûts inutiles.

- FN : cas positifs manqués — souvent critique en santé ou sécurité.

- TN : négatifs correctement ignorés — indique la bonne spécificité globale.

Argument : connaître ces composantes permet de traduire des métriques techniques en décisions métier (ex. prioriser le rappel pour un dépistage).

Phrase-clé : TP FP TN FN ne sont pas que des abréviations — ce sont des leviers actionnables pour améliorer la performance modèle.

Interpréter la matrice de confusion : métriques essentielles pour l’évaluation de modèle

Une matrice brute devient utile quand on en tire des mesures interprétables. Les plus courantes sont la Précision, le Rappel (sensibilité), le Score F1 et l’Exactitude. Elles résument différents aspects de la performance et aident à mesurer les compromis.

Concrètement, chacune répond à une question précise : est-ce que mes positives prédites sont fiables ? Est-ce que je manque des positifs réels ?

- Précision = TP / (TP + FP) — utile quand les faux positifs coûtent cher.

- Rappel (sensibilité) = TP / (TP + FN) — critique quand on ne peut pas se permettre de rater des cas.

- Score F1 = l’harmonique précision/rappel — bon compromis sur jeux déséquilibrés.

- Exactitude = (TP + TN) / total — attention aux jeux déséquilibrés où l’exactitude masque les défauts.

Argument : choisir quelle métrique optimiser dépend du contexte métier. Par exemple, dans un système anti-spam on peut tolérer quelques FN pour éviter trop de FP qui nuisent à l’expérience utilisateur.

Phrase-clé : garder à l’esprit Sensibilité et spécificité permet d’aligner la métrique sur le risque réel encouru.

Comment lire ces métriques dans la pratique

On commence par calculer les métriques sur un jeu de test représentatif. Ensuite, on regarde les déséquilibres de classes et on décide d’un objectif prioritaire (p.ex. maximiser le rappel).

Si Sophie voit un rappel faible mais une précision élevée, elle privilégiera des actions qui réduisent les FN.

- Vérifier distribution des classes avant d’interpréter l’exactitude.

- Utiliser le score F1 pour un compromis quand précision et rappel sont toutes deux importantes.

- Comparer courbes ROC et PR pour décisions sur le seuil.

Phrase-clé : la bonne métrique est celle qui reflète le coût réel des erreurs de classification dans votre produit.

Exemples matrice de confusion : cas concrets et implications métier

Rien ne parle mieux que des cas réels. ClinicoData a testé son modèle de dépistage et obtenu une matrice où les FN étaient particulièrement nombreux. Ce type d’erreur peut entraîner des conséquences médicales graves, donc l’équipe a revu son seuil de décision.

Autre exemple : un filtre anti-spam avec beaucoup de FP provoque des plaintes utilisateurs ; on préfère réduire les FP même si cela augmente légèrement les FN.

- Diagnostic médical : prioriser le rappel pour ne pas rater de malades.

- Filtre anti-spam : prioriser la précision pour éviter de bloquer des mails importants.

- Classification d’images (ex. qualité industrielle) : équilibre selon coût d’un faux rejet vs. réinspection manuelle.

Argument : chaque cas impose un arbitrage métier. Le même nombre d’erreurs peut avoir une signification très différente selon le domaine.

Phrase-clé : étudier des Exemples matrice de confusion aide à traduire des chiffres en décisions opérationnelles.

Améliorer la performance modèle : actions concrètes basées sur l’analyse des prédictions

L’analyse des cases de la matrice oriente les corrections. Si les FP sont nombreux, on repense les features et la spécificité. Si les FN dominent, on augmente la sensibilité via données ou algorithmie.

Voici une check-list d’options pratiques que Sophie applique systématiquement avant toute mise en production.

- Ajuster le seuil de classification pour déplacer le compromis précision/rappel.

- Ré-échantillonnage : sur-échantillonner la classe minoritaire ou utiliser des poids de classes.

- Enrichir les données : ajouter cas limites, augmenter la diversité du jeu d’entraînement.

- Modifier l’architecture ou choisir un autre algorithme mieux adapté au déséquilibre.

- Calibration des probabilités (Platt scaling, isotonic) pour des décisions plus fines.

Argument : l’amélioration passe rarement par une seule action ; on combine données, modèle et seuils pour obtenir un gain durable.

Phrase-clé : l’Analyse des prédictions transforme la matrice en plan d’action itératif et mesurable.

Visualisation et outils pratiques pour l’analyse de la matrice de confusion

Visualiser la matrice facilite l’interprétation pour les décideurs techniques et métiers. Des heatmaps colorées montrent rapidement où concentrer les efforts.

Outils courants en 2025 : scikit-learn pour calculer la matrice, Seaborn/Matplotlib pour les heatmaps, et des dashboards (Grafana, Looker) pour surveiller l’évolution en production.

- Utiliser confusion_matrix de scikit-learn pour générer les counts.

- Plotter une heatmap (Seaborn) avec annotations pour partager avec les parties prenantes.

- Surveiller en production : alerter si la distribution TP/FP/FN/TN évolue brusquement.

Argument : une bonne visualisation réduit le temps pour comprendre un problème et accélère les corrections.

Phrase-clé : visualiser, documenter et monitorer la matrice est la meilleure manière d’assurer la robustesse d’un modèle en production.

À quoi sert principalement la matrice de confusion ?

La matrice de confusion sert à comparer les prédictions d’un modèle de classification aux valeurs réelles. Elle détaille les TP FP TN FN, ce qui permet d’identifier le type d’erreurs (faux positifs vs faux négatifs) et d’orienter des actions pour améliorer la performance du modèle.

Quelle métrique choisir entre précision, rappel et F1 ?

Choisissez la métrique qui reflète le coût métier des erreurs. Si rater un positif est critique (ex. dépistage), privilégiez le rappel. Si les fausses alertes sont coûteuses (ex. spam), privilégiez la précision. Le score F1 est un bon compromis quand précision et rappel sont toutes deux importantes.

Comment réduire les faux négatifs sans trop augmenter les faux positifs ?

Plusieurs leviers : ajuster le seuil de décision, sur-échantillonner la classe positive, appliquer des poids de classes, enrichir les données pour mieux représenter les cas rares, ou utiliser des modèles plus sensibles. La calibration des probabilités aide aussi à prendre des décisions plus fines.

Quels outils permettent de visualiser efficacement une matrice de confusion ?

Des bibliothèques Python comme scikit-learn (pour calcul), Seaborn/Matplotlib (pour la heatmap) et des dashboards (Grafana, Looker) pour le suivi en production sont les plus utilisés. La visualisation doit inclure annotations et proportions pour un partage clair avec les métiers.