Idée essentielle : Alibaba Qwen3‑Coder met l’open source au cœur du coding agentique : un modèle de 480 milliards de paramètres, conçu pour gérer des projets complets, rivaliser avec GPT‑4o et Claude 3.5, et rendre l’IA de développement accessible, modifiable et intégrable dans des workflows industriels.

Depuis sa sortie officielle le 24 juillet 2025, Qwen3‑Coder s’impose comme une alternative sérieuse aux modèles propriétaires. Son architecture Mixture‑of‑Experts active seulement 35 milliards de paramètres par jeton, ce qui optimise la vitesse et les coûts d’inférence. Grâce à une fenêtre contextuelle native de 256 000 tokens (extensible jusqu’à 1 million), il peut ingérer des bases de code entières et orchestrer des tâches multi‑étapes via des agents. Concrètement : un développeur peut déléguer la conception, les tests et la documentation à des agents coordonnés — et garder la main sur la stratégie.

- Open source et distribuable (Apache‑2.0).

- Fenêtre contextuelle très longue pour projets multi‑modules.

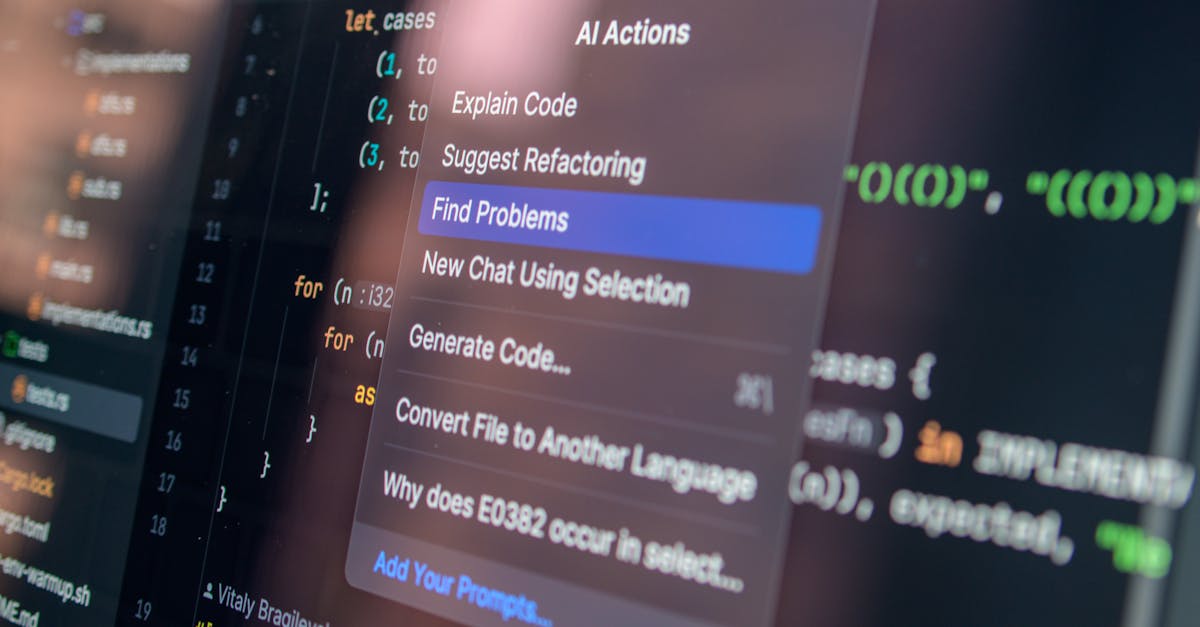

- Outil CLI (Qwen Code) et intégration dans Tongyi Lingma et IDE (VS Code).

- Concurrence directe avec GPT‑4o et Claude 3.5 sur le coding agentique.

Qwen3‑Coder : architecture, capacités et ce qui le rend différent

Ce qu’il faut retenir d’emblée : Qwen3‑Coder n’est pas juste un « gros modèle » — c’est une machine pensée pour le développement logiciel autonome. L’architecture MoE permet d’atteindre 480 milliards de paramètres tout en activant une fraction seulement pendant l’inférence, d’où un meilleur ratio coût/puissance.

Le modèle combine entraînement sur des corpus massifs de code et de texte général, une optimisation par apprentissage par renforcement de long terme (agent RL) et une capacité à orchestrer plusieurs agents (génération, test, documentation). Résultat : il gère des interactions multi‑étapes et l’usage d’outils externes avec robustesse.

Insight : la combinaison MoE + agent RL permet à Qwen3‑Coder de « penser » sur des séquences longues et de réduire les allers‑retours humains lors du debugging.

Fenêtre contextuelle étendue et workflow multi‑agents

Qwen3‑Coder offre par défaut 256 000 tokens et peut être étendu jusqu’à 1 million grâce à des techniques d’extrapolation. Concrètement, une équipe peut charger l’intégralité d’un dépôt multi‑module et demander des refactors, des tests unitaires et un plan de migration. C’est ce qui fait la différence face à des modèles conçus pour des échanges plus courts.

Par exemple, l’équipe fictive « NovaTech » a confié à Qwen3‑Coder la modernisation d’un monolithe Java : génération des tests, découpage en microservices, et scripts CI/CD. La coordination entre agents a réduit le temps de mise en production de plusieurs semaines.

Insight : travailler sur de gros dépôts devient possible sans fragmenter le contexte — on garde la vue d’ensemble.

Cas d’usage concrets : où Qwen3‑Coder apporte un vrai gain

Allons droit au but : Qwen3‑Coder n’est pas un gadget de recherche. Il apporte un avantage pragmatique sur plusieurs fronts. Voici des usages qui reviennent souvent dans les retours terrain :

- Développement web : génération front/back (React, Node.js), prototypage rapide et composants réutilisables.

- Débogage et code hérité : analyse de grandes bases, correction de bugs logiques et suggestions de refactor.

- DevOps & automatisation : génération de scripts de déploiement, workflows CI/CD et intégration d’outils CLI.

- Éducation : tutoriels pas à pas, explications de patterns et exercices corrigés.

- Sécurité : scans de vulnérabilités de base et propositions de correctifs (à compléter par audits humains).

NovaTech, encore une fois, a utilisé Qwen3‑Coder pour créer pipelines de CI automatisés et scripts Terraform ; les développeurs ont ainsi réduit les erreurs manuelles et accéléré les release cycles.

Insight : dans les environnements industriels, Qwen3‑Coder est utile là où la répétition et la complexité se combinent — par exemple le refactoring de systèmes hérités.

Interopérabilité et outils : Qwen Code, IDEs et cloud

Alibaba propose Qwen3‑Coder en open source sur GitHub et Hugging Face, et fournit le CLI Qwen Code pour piloter le modèle avec des prompts structurés. L’intégration avec VS Code et la compatibilité avec des standards (y compris certaines interfaces proches de Claude Code) facilitent l’adoption dans les équipes.

Tongyi Lingma de Alibaba Cloud intègre bientôt ces capacités, offrant un écosystème complet pour déployer des agents en production. Les développeurs peuvent aussi héberger Qwen3‑Coder localement via les images publiques ou utiliser des services managés.

Insight : l’open source + outils CLI = possibilité d’héberger, customiser et intégrer Qwen3‑Coder sans dépendance exclusive à une API payante.

Benchmarks et concurrence : où se situe Qwen3‑Coder face à GPT‑4o et Claude 3.5

En synthèse : Qwen3‑Coder n’atteint pas systématiquement les sommets des modèles propriétaires fermés, mais il offre un compromis rare entre performance, transparence et coût. Sur SWE‑Bench Verified, la version phare affiche un score de 55,40 % en résolution de bugs, ce qui la place parmi les meilleurs modèles open source.

Les leaders fermés peuvent rester devant sur certains benchmarks (par exemple des variantes de Claude ou GPT avec scores supérieurs), mais la différence se réduit lorsque l’on prend en compte la latence, la possibilité d’hébergement local et la personnalisation via apprentissage supplémentaire.

Pour un comparatif plus large entre approches propriétaires et open source, la mise en perspective avec des articles comparatifs aide à comprendre les positions : analyse ChatGPT vs Claude explore ces enjeux de précision et de gouvernance.

Insight : la concurrence entre Alibaba Qwen, GPT‑4o et Claude 3.5 pousse à des choix stratégiques : open source pour le contrôle, fermé pour la performance pure.

Pourquoi choisir open source ?

L’open source apporte trois bénéfices concrets : transparence des données et modèles, possibilité d’adaptation aux contraintes locales, et réduction des coûts d’intégration. Les équipes qui veulent maîtriser leur stack IA et assurer la souveraineté technologique privilégieront Qwen3‑Coder.

Si vous souhaitez explorer des alternatives open source pour l’inférence et l’optimisation, des ressources comme vLLM montrent comment accélérer l’inférence sur des fenêtres de contexte longues.

Insight : choisir open source, ce n’est pas seulement une question d’éthique : c’est une stratégie opérationnelle pour les entreprises qui veulent garder la main.

Adopter Qwen3‑Coder : checklist pratique avant le déploiement

Voici une liste pragmatique pour les équipes qui évaluent Qwen3‑Coder. Elle reprend des retours terrain et des étapes concrètes à suivre.

- Vérifier la compatibilité d’infrastructure (GPU/serveurs) et prévoir optimisation MoE.

- Tester la fenêtre contextuelle sur des cas réels (chargement d’un dépôt complet).

- Mettre en place des garde‑fous pour la sécurité et la revue humaine du code généré.

- Intégrer Qwen Code dans les pipelines CI pour automatiser tests et déploiements.

- Évaluer la nécessité d’un entraînement complémentaire ou d’un fine‑tuning.

Pour des comparaisons d’outils créatifs et d’IA de génération d’images, qui peuvent être utiles pour les interfaces ou la documentation visuelle, voir des tests pratiques comme Getimg AI ou des bilans sur Leonardo AI.

Insight : réussir le déploiement demande autant d’attention au processus qu’au modèle lui‑même.

Risques opérationnels et limites actuelles

Qwen3‑Coder n’est pas une baguette magique. Les principales limites à considérer sont : fausses suggestions sur les cas très spécifiques, nécessité d’audits de sécurité complémentaires, et besoins matériels élevés pour héberger les plus grandes versions.

Dans les environnements réglementés, préférez un pipeline de revue humaine et des tests de sécurité dédiés avant la mise en production. Pour s’inspirer de débats sur la gouvernance et la sécurité des IA, consultez des analyses sur l’actualité des assistants et copilots, par exemple les intégrations Copilot de Microsoft.

Insight : la prudence opérationnelle et la supervision humaine demeurent incontournables.

Ressources et écologie de l’écosystème Qwen

Qwen3‑Coder est disponible sur GitHub (QwenLM/Qwen3‑Coder) et Hugging Face ; il est accompagné d’outils et d’une communauté active. Alibaba a montré qu’il visait des intégrations profondes avec ses services cloud et ses environnements IDE, tout en cherchant à séduire les développeurs via la licence Apache‑2.0.

Si vous suivez l’évolution des assistants de code et des stratégies industrielles autour de l’IA, des articles comme guides et analyses ChatGPT ou des bilans sur l’économie des modèles peuvent aider à cadrer votre roadmap. Pour du contexte économique et d’investissement dans l’IA, des réflexions comme investir dans OpenAI montrent que le marché pèse autant que la technologie.

Insight : l’écosystème est autant technique que communautaire — contributeurs et intégrateurs feront la valeur réelle du modèle.

Qwen3‑Coder est‑il gratuit pour un usage commercial ?

Oui. Le modèle est publié sous licence Apache‑2.0, ce qui permet un usage commercial et une personnalisation, tout en respectant les obligations de la licence.

Quelle est la différence principale entre Qwen3‑Coder et GPT‑4o ?

Qwen3‑Coder mise sur l’open source, la modularité MoE et la fenêtre contextuelle extrême, permettant l’hébergement local et la personnalisation. GPT‑4o reste une solution performante mais majoritairement propriétaire et gérée via API payante.

Peut‑on utiliser Qwen3‑Coder sur un poste local ?

Oui : des versions et checkpoints sont disponibles sur GitHub/Hugging Face et peuvent être déployés localement, à condition de disposer de l’infrastructure GPU nécessaire ou d’optimisations d’inférence.

Comment Qwen3‑Coder gère‑t‑il la sécurité du code ?

Le modèle fournit des analyses et suggestions pour détecter des vulnérabilités basiques, mais il ne remplace pas un audit de sécurité complet. Il est conseillé d’associer la revue humaine et des outils spécialisés.